搜索引擎结果页面 (SERP) 用于导航万维网并查找与给定查询相关的信息。对于那些希望了解最新行业新闻或为即将进行的项目收集研究的人来说,了解如何快速有效地导出 Google 搜索结果并以易于理解的形式组织它们至关重要。无论您的任务规模有多大,掌握导出 Google 搜索结果并将数据组织成一致格式的能力都可以节省您的时间并帮助您的项目取得成功。

在本文中,我们将指导您完成从 Google 搜索引擎结果页自动收集大量 SERP 数据的不同步骤,并提供如何将数据导出到 CSV 文件的示例。通过自动化 SERP 抓取过程,您可以快速收集必要的数据并轻松导出,以便您可以将注意力集中在分析或其他任务上。

带有 Google 搜索 API 的 Google 表格

注意:需要付费的 Google API 密钥

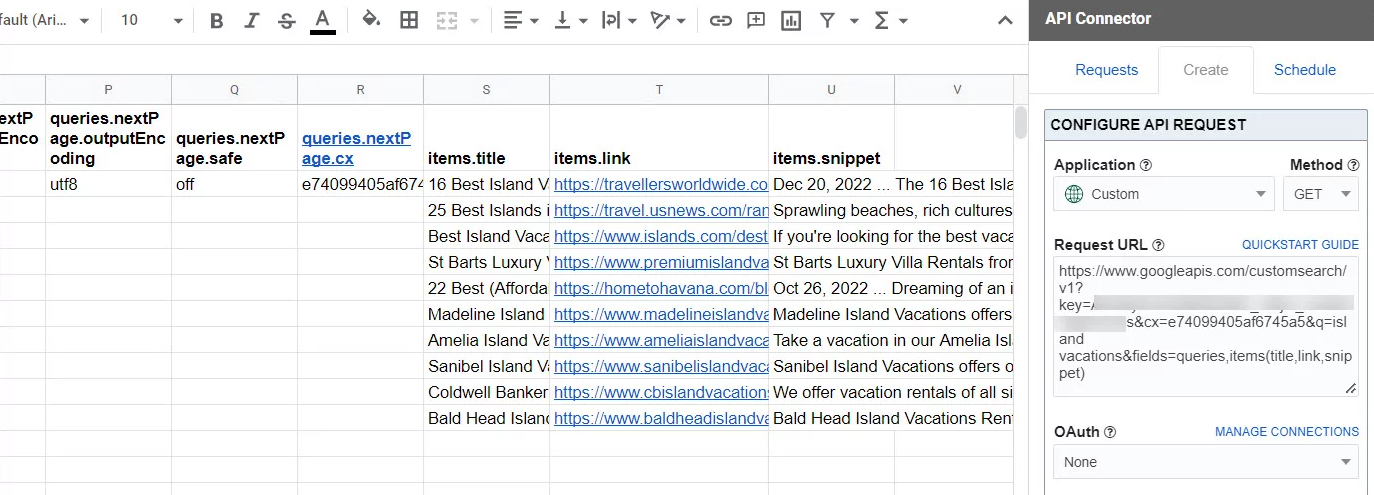

自动收集 Google SERP 数据的一种简单且免费的方法是将 Google Sheets 与 Google Search API 结合使用。此方法需要 Google Sheets 的基本知识和 Google Developers 提供的免费 API 密钥。操作方法如下:

a. 打开新的 Google 表格并转到“扩展”菜单。

b. 选择“附加组件”并在市场中搜索“SERP API”。

c. 单击“+免费”按钮安装该附加组件。

d. 安装后,从“扩展”菜单中打开插件并输入您的 API 密钥。

e. 在附加界面中指定关键字和其他参数,然后单击“运行”以检索 SERP 数据。

Google 搜索 API(自定义搜索 JSON API)定价

自定义搜索 JSON API 每天免费提供 100 个搜索查询。如果您需要更多,您可以注册计费 在 API 控制台中。额外请求的费用为每 1000 个查询 5 美元,每天最多 10,000 个查询。

- 自动收集 Google SERP 数据的简单方法

- 需要 Google 表格的基本知识

- 来自 Google Developers 的免费 API 密钥

缺点:

- 需要付费的 Google API 密钥

- 依赖于 Google Sheets 和 Google Search API

- Google API 的 SERP 结果不是最新的

(免费)如何使用 SCOHalo SERP 分析器获取 Google SERP 并导出到 csv

SCOHalo SERP 分析器是一个功能强大的工具,允许用户获取 Google 搜索引擎结果页 (SERP) 数据并将其轻松导出为 CSV 格式。在本文中,我们将分步说明如何使用 SCOHalo SERP 分析器获取 Google SERP 并将其导出到 CSV 文件以供进一步分析。

第 1 步:下载并安装 SCOHalo SERP 分析器

首先,您需要在计算机上下载并安装 SCOHalo SERP 分析器。访问官方网站并找到下载链接。下载后,运行安装程序并按照屏幕上的说明完成安装过程。

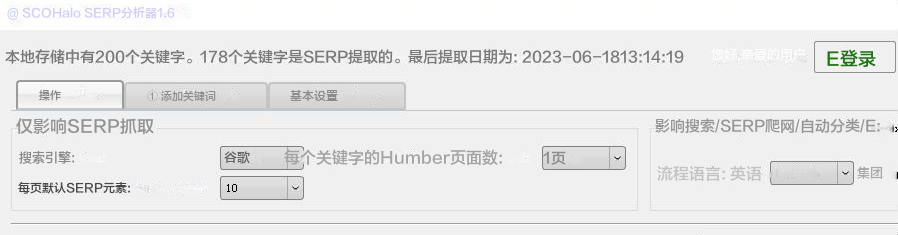

第 2 步:启动 SCOHalo SERP 分析器

安装后,双击桌面上的应用程序图标或在程序文件中找到它来启动 SCOHalo SERP 分析器。该工具将以干净且用户友好的界面打开。

![[免费]如何使用 SCOHalo SERP 分析器获取 Google SERP 并导出到 csv](/uploadimg/cn/2023/7/2023-07-17-11_50_43_2d26d31240224eee927e4a006a3ad5ef.png)

步骤 3:配置搜索引擎和关键字

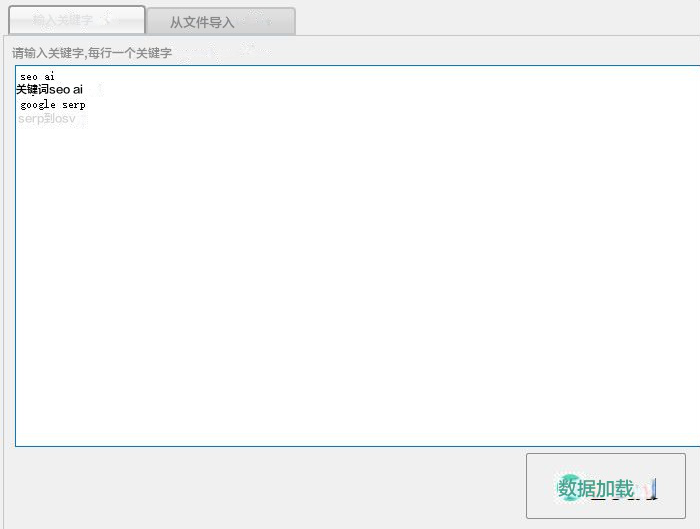

在 SCOHalo SERP 分析器界面中,您会发现一个搜索栏,您可以在其中输入要分析的关键字。此外,您可以从下拉菜单中选择所需的搜索引擎。默认情况下,会选择 Google,但您可以选择其他搜索引擎,例如 Bing 或 Yahoo。

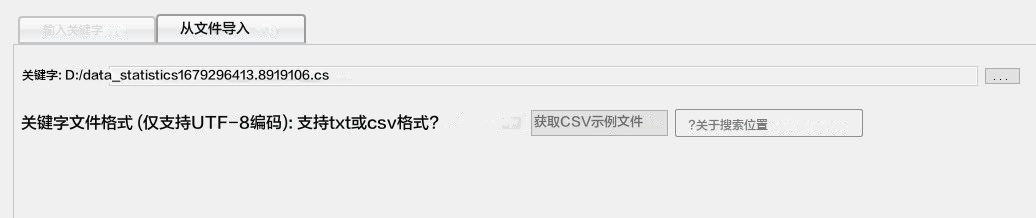

您可以从 csv 文件或文本中输入关键字(每行一个关键字)。

如果您想从 csv 文件导入,您可以点击“ 获取 CSV 示例文件 ” 下载示例 csv 文件。

第 4 步:设置代理(可选)

如果您想使用代理服务器来获取SERP数据,您可以在“代理”选项卡中进行配置。此步骤是可选的,如果不需要代理,可以跳过它。

第 5 步:开始 SERP 分析

输入关键字并配置任何必要的代理设置后,单击“ 开始抓取 SERP ”按钮启动SERP分析过程。SCOHalo SERP分析器将向搜索引擎查询指定的关键词并获取相应的SERP数据。

第 6 步:将 SERP 数据导出到 CSV

分析完成后,您可以将获取的 SERP 数据导出到 CSV 文件。为此,请单击“导出”按钮,这将打开一个窗口,提示您选择目标文件夹并指定文件名。做出必要的选择后,单击“保存”导出数据。

第7步:分析导出的数据

现在您已成功将 SERP 数据导出到 CSV 文件,您可以使用任何电子表格软件(例如 Microsoft Excel 或 Google Sheets)打开它。 CSV 文件将包含代表 SERP 不同方面的各个列,例如搜索位置、URL、标题、摘要等。您现在可以执行进一步的分析并从数据中提取有意义的见解。

总之,SCOHalo SERP 分析器是一个方便的工具,用于获取 Google SERP 数据并将其导出到 CSV 文件。通过遵循上述分步说明,您可以轻松使用此工具收集有价值的数据,以进行 SEO 分析、竞争对手研究和内容优化。

额外功能:

获取关键字的所有 SERP 结果后,您可以 使用 SCOHalo SERP 分析器将关键字与 SERP 结果分组

- 用于获取 Google SERP 数据的强大工具

- 轻松导出为 CSV 格式

- 易于使用的分步说明

- 干净且用户友好的界面

- 配置代理服务器的选项

缺点:

- 需要独立IP以避免bot检查

使用 Google Data Studio 和 SEO 工具自动收集和导出 SERP 数据

注意:您需要有一个付费帐户 Ahrefs 或 SEMrush

第 1 步:设置 Google Data Studio

– 打开 Google Data Studio 并使用您的 Google 帐户登录。

– 点击左上角的“创建”并选择“空白报告”。

– 单击“创建新数据源”添加新数据源。

– 选择“Google 表格”作为连接器,然后选择要存储导出的 SERP 数据的 Google 表格。

– 选择适当的工作表并单击“连接”。

– 自定义您想要包含在报告中的字段和指标,例如“关键字”、“排名”、“URL”和“搜索量”。

– 单击“创建报告”以根据您的数据源生成报告。

步骤2:配置SEO工具进行数据导出

– 使用 SEO 工具,例如 Ahrefs 或 SEMrush 收集 SERP 数据。

– 将收集的数据导出到 CSV 文件。

– 使用 Google 表格打开 CSV 文件。

– 确保 CSV 文件中的列标题与 Data Studio 报告中的字段匹配。

第 3 步:自动导入数据

– 在 Google Data Studio 中,转到您在步骤 1 中创建的报告。

– 单击右侧的“数据源”选项卡。

– 单击三点菜单图标并选择“数据源设置”。

– 在“数据”选项卡下,单击“自动刷新数据”。

– 设置所需的数据刷新频率,例如每天或每周。

– 单击“保存”以应用更改。

第 4 步:将 SERP 数据导出到 CSV

– 导入并刷新数据后,您可以将其导出到 CSV 文件。

– 在 Google Data Studio 中,转到您创建的报告。

– 单击左上角的“文件”,然后选择“导出”>“CSV”以下载文件。

– 在设备上选择一个位置来保存导出的 CSV 文件。

– CSV 文件将包含您的 SERP 数据,包括关键字、排名、URL 和搜索量。

通过遵循这些分步说明,您可以使用 Google Data Studio 和其他 SEO 工具自动收集 SERP 数据并将其导出到 CSV 文件。这使您可以有效地分析和跟踪您的网站在搜索引擎排名中的表现。

- 允许自动收集和导出 SERP 数据

- 与其他 SEO 工具集成以进行数据收集

- 可定制的字段和指标以进行全面分析

- 自动数据导入和刷新以获取最新信息

- 轻松将 SERP 数据导出到 CSV 文件

缺点:

- 依赖于使用其他SEO工具进行数据收集

- 需要熟悉 Google Data Studio 及其设置过程

网页抓取编程工具

注意:需要了解如何使用python语言

另一种大规模自动收集 Google SERP 数据的方法是通过 Scrapy 或 BeautifulSoup 等网络抓取工具。这种方法需要更多的技术知识,但它可以让您更好地控制抓取过程。下面是一个使用 BeautifulSoup 和 Python 的简化示例:

a. 安装 BeautifulSoup 并请求库 Python 。

b. 写一个 Python脚本 向 Google 发送搜索查询并使用以下命令解析 HTML 响应 BeautifulSoup 。

代码示例:

|

c. 从解析的 HTML 中提取所需的数据并将其保存到 CSV 或数据库中。

总结

| 产品名称 | 特征 | 价格 | 设想 |

|---|---|---|---|

| 带有 Google 搜索 API 的 Google 表格 | 自动收集Google SERP数据/ Google Sheets的基础知识/ Google Developers提供的免费API密钥缺点:操作复杂/需要支付API调用费用 | 有薪酬的 | 将 Google Sheets 与 Google Search API 结合使用来检索 SERP 数据 |

| 具有 SERP 抓取功能的 SEO 工具 | SERP 抓取功能/关键字分析/CSV 或 Excel 导出缺点:需要付费帐户/昂贵 | 变化(付费) | 使用 Moz/ Ahrefs/ 或 SEMrush 等 SEO 工具批量收集和分析 SERP 数据 |

| 网页抓取库 | 网页抓取/ Python 脚本/数据提取/ CSV 或数据库存储缺点:需要了解 Python 编程语言 | 自由的 | 使用 Scrapy 或 BeautifulSoup 等网络抓取工具批量自动收集 Google SERP 数据 |

| SCOHalo SERP 分析器 | 易于使用 GUID。自动收集大量关键词的Google SERP数据。将关键词与SERP结果进行分组。缺点:需要独立IP进行抓取| | 自由的 | 独立程序,无需额外费用 |

要优化 Google 搜索结果的收集,请使用特定参数和过滤器来优化结果。

一种有效的方法是使用引号来精确匹配短语。例如,搜索“最佳智能手机”将仅显示包含确切短语“最佳智能手机”的结果,以确保更相关的结果。

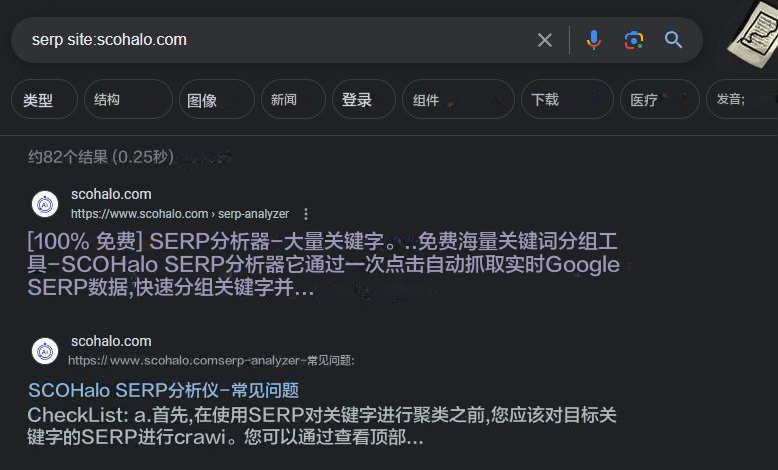

参数“站点:”

此外,使用“site:”运算符允许用户在特定网站或域内进行搜索。例如,搜索“ 网站:wikipedia.org 人工智能 ” 只会显示来自维基百科网站的与人工智能相关的结果。

参数“文件类型:”

此外,在查找特定文件类型时,使用“filetype:”参数很有用。例如,使用“ 文件类型:pdf 气候变化 ” 将仅显示与气候变化相关的 PDF 文件。

范围 ”-”

此外,在特定术语之前使用减号“-”会排除包含该术语的结果。例如,搜索“ 汽车-电动 ” 将显示与汽车相关的结果,但不显示与电动汽车相关的结果。

参数“日期”

最后,利用“日期”过滤器有助于将搜索结果缩小到特定的时间范围。这在研究最新信息或历史数据时非常有价值。

通过使用这些特定的搜索参数和过滤器,用户可以优化他们的收集过程并获得更准确和相关的Google搜索结果。

总之,将 Google SERP 数据导出到 CSV 既高效又节省时间。它为营销人员、研究人员和商业专业人士提供了宝贵的见解。通过使用先进的工具,可以简化数据收集,并提取有意义的信息进行分析。这种方法可以跟踪关键词排名、监控竞争对手并进行市场研究。批量导出搜索结果可以轻松分析趋势并识别机会。实施这种自动化方法可以释放您在线策略的全部潜力。